网站建设搜狐明星百度指数排名

Transformer架构

- encoder和decoder区别

Embeddings from Language Model (ELMO)

- 一种基于上下文的预训练模型,用于生成具有语境的词向量。

- 原理讲解

- ELMO中的几个问题

Bidirectional Encoder Representations from Transformers (BERT)

- BERT就是原生transformer中的Encoder

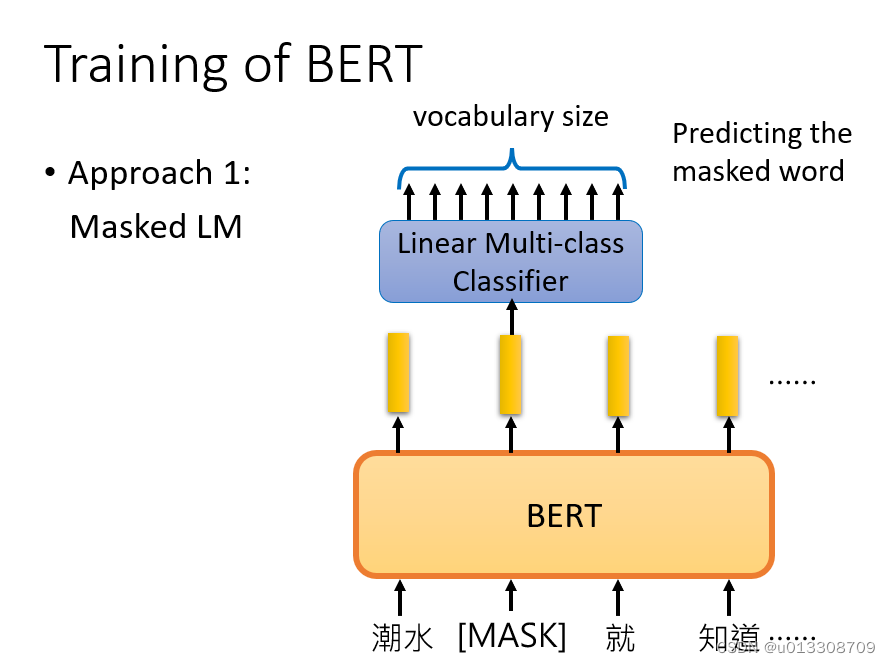

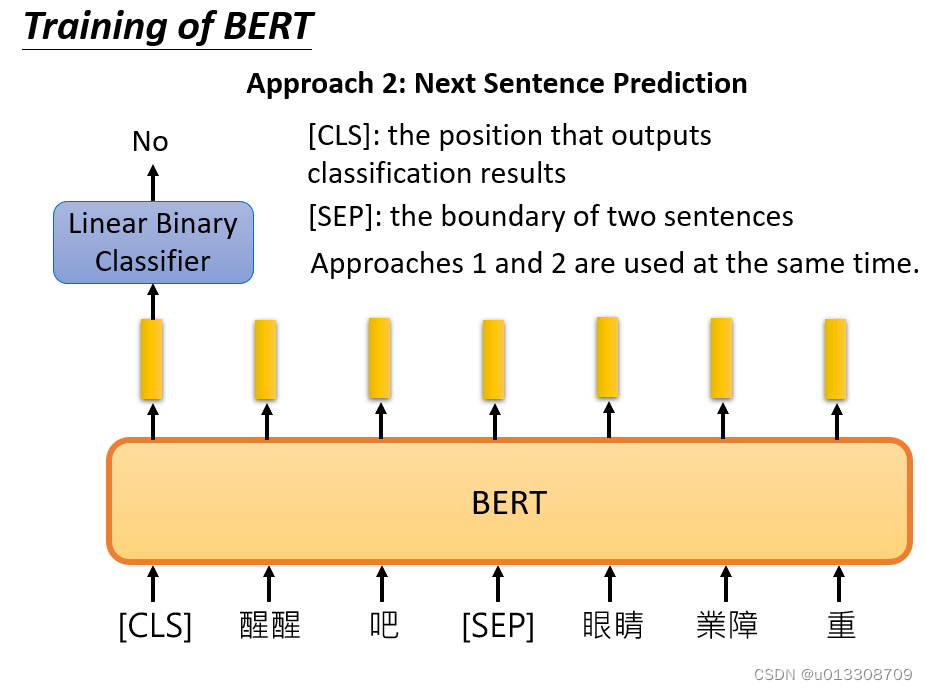

- 两个学习任务:MLM和NSP

-

Masked Language Model:将输入句子中的某些token随机替换为[MASK],然后基于上下文预测这些被替换的token。学习局部语义和上下文依赖关系。这有助于BERT理解每个词的表达。

-

-

Next Sentence Prediction:给定一对句子A和B,判断B是否是A的下一句。这可以学习句子之间的关系,捕获上下文信息,有助于BERT在文档层面上理解语言。

-

- 李宏毅BERT

- BERT

Enhanced Representation through Knowledge Integration (ERNIE)

- ERNIE提出了Knowledge Masking的策略,ERNIE将Knowledge分成了三个类别:token级别(Basic-Level)、短语级别(Phrase-Level) 和 实体级别(Entity-Level)。通过对这三个级别的对象进行Masking,提高模型对字词、短语的知识理解。

- 预训练模型ERINE

- ERINE的改进

Generative Pre-Training (GPT)

-

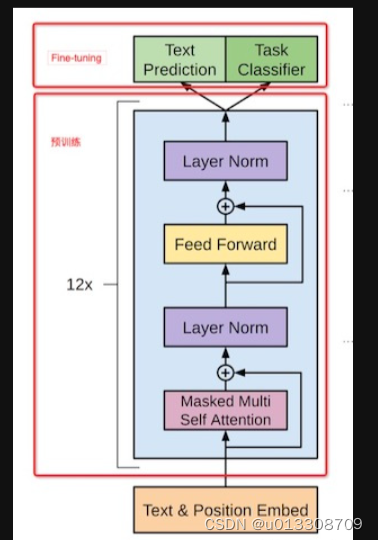

GPT 使用 Transformer 的 Decoder 结构,并对 Transformer Decoder 进行了一些改动,原本的 Decoder 包含了两个 Multi-Head Attention 结构,GPT 只保留了 Mask Multi-Head Attention。

-

-

GPT

-

GPT阅读